+

+  +

+

+ +[English](../README.md) | 简体中文 + + +

+

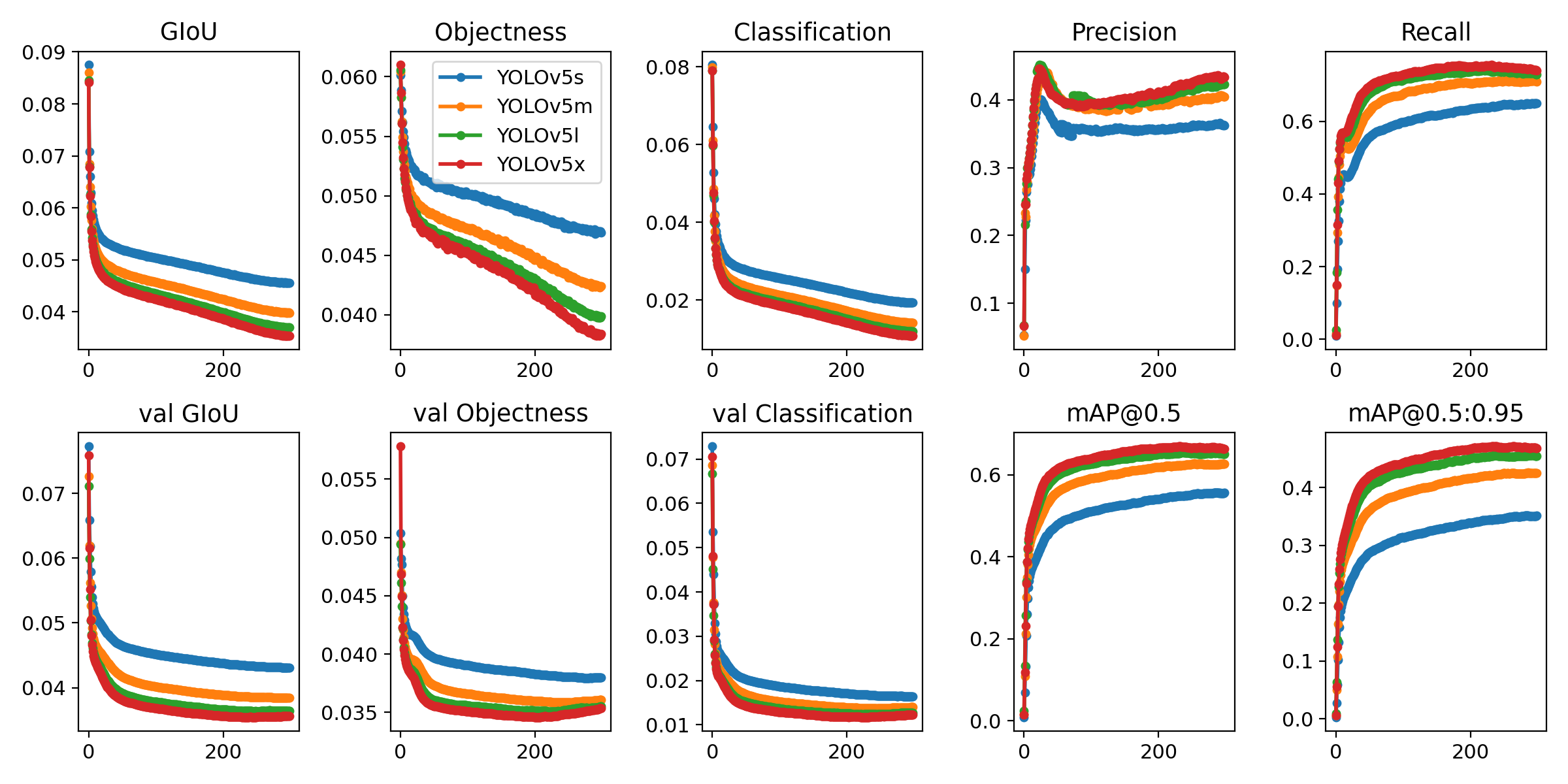

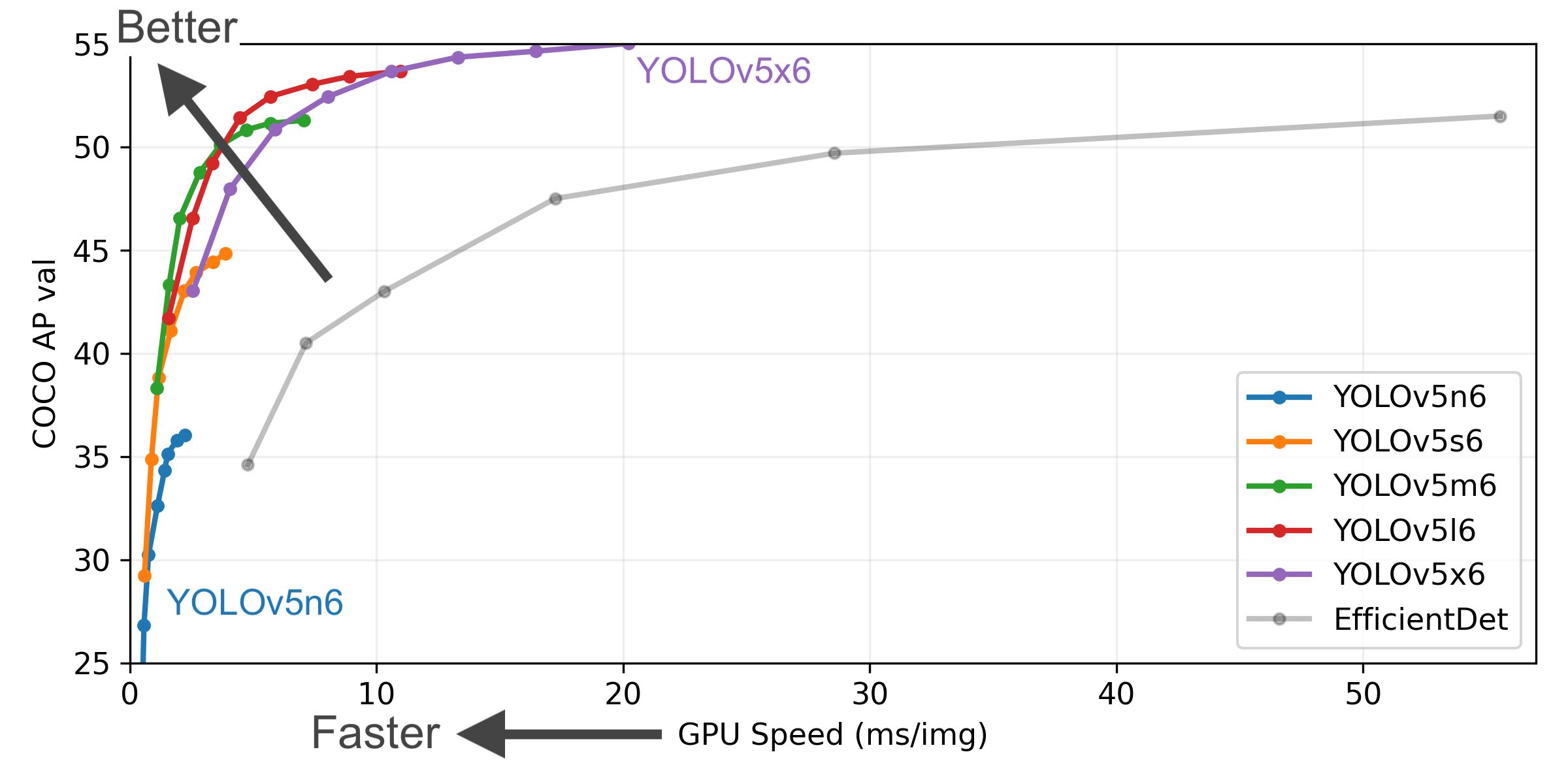

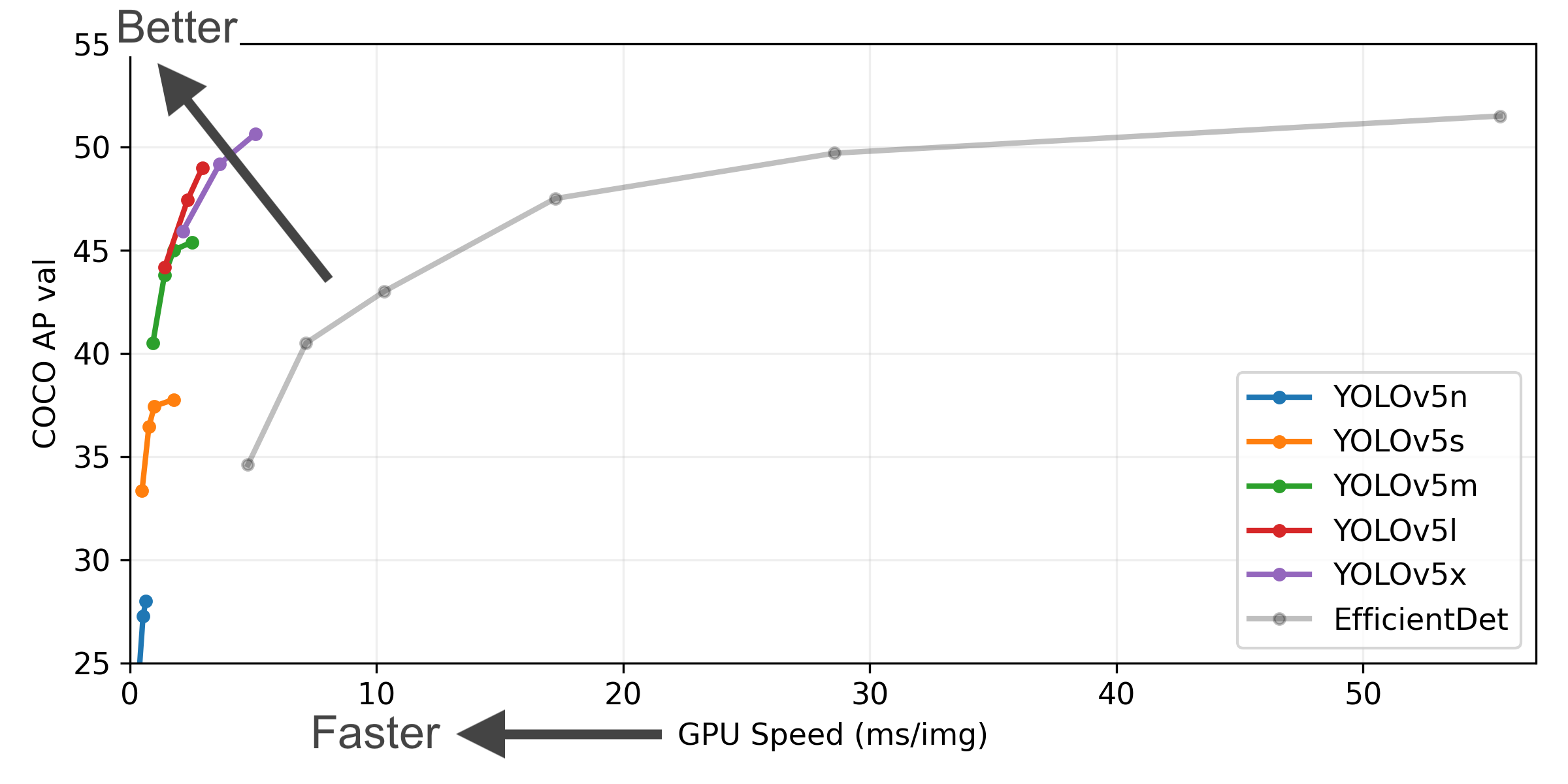

+YOLOv5🚀是一个在COCO数据集上预训练的物体检测架构和模型系列,它代表了Ultralytics对未来视觉AI方法的公开研究,其中包含了在数千小时的研究和开发中所获得的经验和最佳实践。 +

+ + + + + +

+

+  +

+

+YOLOv5🚀是一个在COCO数据集上预训练的物体检测架构和模型系列,它代表了Ultralytics对未来视觉AI方法的公开研究,其中包含了在数千小时的研究和开发中所获得的经验和最佳实践。 +

+ + + + + + +

+

+

+

+

+English | [简体中文](.github/README_cn.md)

+

+English | [简体中文](.github/README_cn.md)